Als Eingabe erwarten Modelle wie Stable Diffusion, Midjourney oder DALL-E 2 bislang entweder ein bereits vorhandenes Bild (pic2pic) oder eine Texteingabe (text2pic), mittels derer ein Bild generiert wird. Doch eigentlich sind diese Eingabe-Texte und -Bilder "nur" Koordinaten in einem Raum mit sehr vielen Dimensionen, dem sogenannten Latent Space. Ein entsprechender Eingabe-Satz (der sogenannte Prompt) deutet also nur auf einen Punkt in diesem Latent Space, der anschließend das Bild durch eine sehr große, aber feste Formel mit diesen Koordinaten als Parameter erzeugt.

Ist nur ein einziges (Satz)-Zeichen im Prompt anders, so zeigt dieser auf eine ganz andere Stelle im Latent Space und errechnet somit auch ein komplett anderes Bild. Zudem bestimmt eine Startzufallszahl (die sogenannte Seed) wie das Rauschen erstellt wird, das den Ausgangszustand der Bildberechnung darstellt. Ändert man auch nur nur eine Ziffer in der Seed, erhält man ebenfalls ein komplett anderes Bild.

Mehr Zufall als Kontrolle

Die bisherige Arbeitsweise mit KI-Bildgeneratoren besteht also darin, beim Prompting viele Kombinationen auszuprobieren und irgendwann mit einem ausgespuckten Ergebnis zufrieden zu sein. Will man beispielsweise eine bestimmte Körperhaltung oder einen Kamerawinkel im Bild haben, so muss man dies bei der Texteingabe beschreiben und hoffen, dass die KI das auch entsprechend deutet - was keineswegs selbstverständlich funktioniert, sondern in der Regel eher daneben geht. Auch wenn man ein Bild als Input verwendet, ist es keineswegs sicher, dass die KI beispielsweise auch dessen Kamerawinkel übernimmt. Die Erzeugung ist also aktuell sehr stark von Trial and Error bestimmt und für jedes gelungene Bild, das medial bestaunt werden kann, wurden in der Regel zuvor hunderte misslungene Versuche verworfen. In den meisten Fällen landet man zwar irgendwann bei einem überraschend guten Ergebnis, jedoch war dessen konkrete Bildkomposition meistens keineswegs vom Anwender vorher exakt geplant...

Doch genau dies könnte sich nun mit ControlNet ändern, das seit einigen Tagen durch die StableDiffusion-Community geistert. Control Net erlaubt es, den Text Prompt mit einem zusätzlichen Bild zur Erläuterung der eigenen Idee zu füttern. Und damit eine Richtung der Bildkomposition vorzugeben, wie Gegenstände und Menschen im Bild angeordnet sein sollen.

Gamechanger durch mehr Kontrolle?

Die bislang veröffentlichten Beispiele zeigen bereits deutlich das Potential dieser neuen Technologie und in den Kommentaren fiel seit längerem auch mal wieder der Begriff "Gamechanger". Doch zurecht?

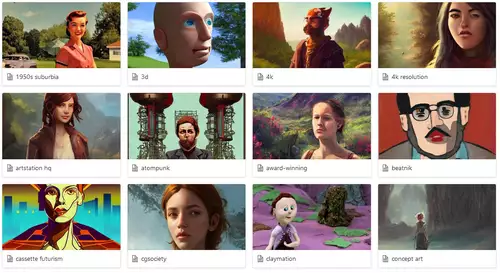

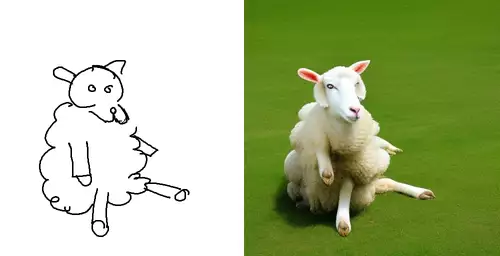

Nach allem, was wir bisher gesehen (und selbst ausprobiert haben), erweitert ControlNet die Möglichkeiten der KI-Bilderzeugung deutlich. Allerdings muss man zur Bedienung (noch) von Hand speziell angepasste Modelle einbinden. Diese Modelle bestimmen, an welcher Art von Bildvorlagen sich ControlNet anschließend orientieren soll. Hier kann man beispielsweise ein "Scribble Modell" wählen, welches einfache Skizzen als Input akzeptiert:

Oder ein Modell für Strichmännchen-Posen:

Oder ein Modell mit Z-Puffer Tiefeninformationen als Input:

Wer etwas Zeit mitbringt, kann ControlNet aktuell selbst auf Hugginface online ausprobieren - sogar ohne auf seinem Rechner etwas installieren zu müssen. Die dort kostenlos zur Verfügung gestellte Umgebung ist allerdings bei der Berechnung der Prompts ziemlich langsam und benötigte bei uns pro Änderung mindestens zwei Minuten Rechenzeit. Dies Zeiten sind jedoch stark davon abhängig, wie viele Nutzer aktuell mit ControlNet herumspielen.